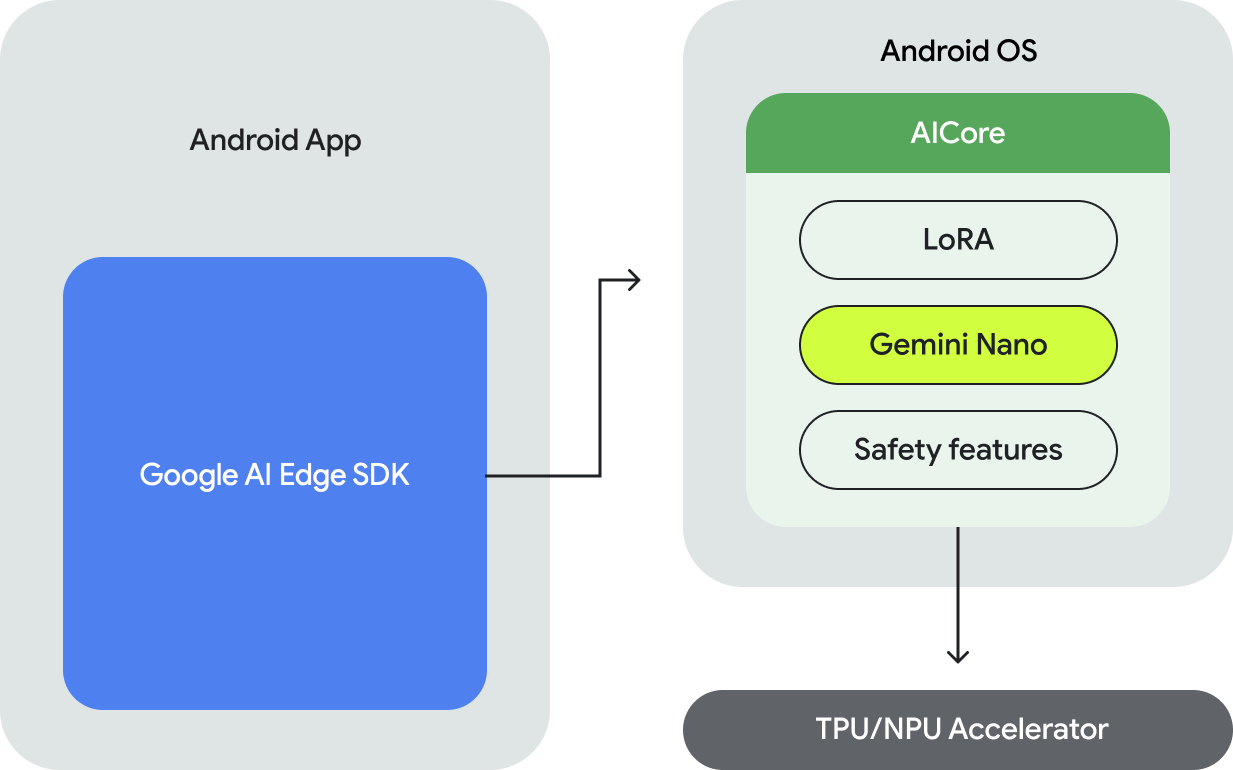

Google AI Edge SDK 允许开发者实验性访问,以通过 Gemini Nano 在设备端 AI 功能增强其应用。

通过 AICore 实现架构

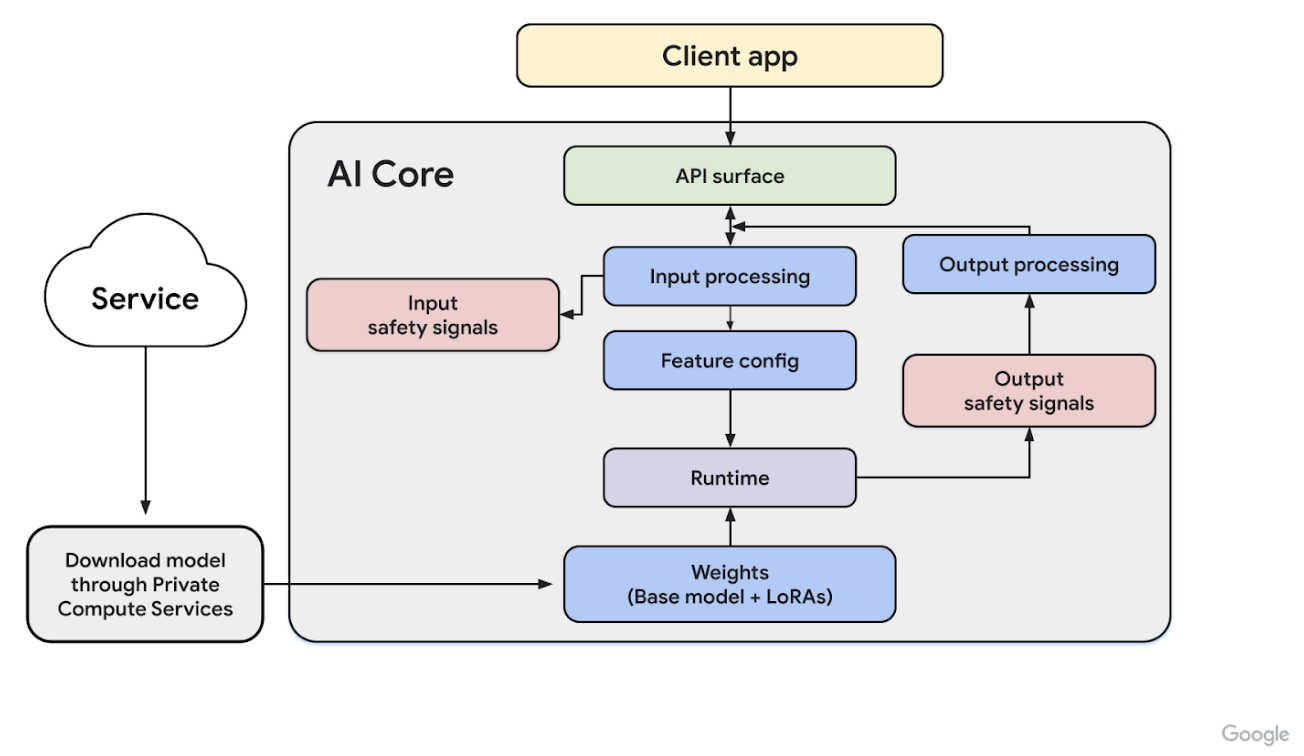

作为一个系统级模块,你通过一系列 API 访问 AICore,以便在设备端运行推理。此外,AICore 具有多项内置安全功能,确保针对我们的安全过滤器进行彻底评估。下图概述了应用如何访问 AICore 以在设备端运行 Gemini Nano。

保护用户数据私密和安全

设备端生成式 AI 在本地执行提示,无需服务器调用。这种方法通过将敏感数据保留在设备上增强了隐私,实现了离线功能,并降低了推理成本。

AICore 遵循 Private Compute Core 原则,具有以下主要特征:

- 受限软件包绑定:AICore 与大多数其他软件包隔离,仅对特定系统软件包有少数例外。对此允许列表的任何修改只能在完整的 Android OTA 更新期间进行。

- 间接互联网访问:AICore 不具备直接互联网访问权限。所有互联网请求(包括模型下载)都通过开源 Private Compute Services 伴侣 APK 进行路由。Private Compute Services 中的 API 必须明确展示其以隐私为中心的特性。

此外,AICore 的构建旨在隔离每个请求,并且在处理后不存储任何输入数据或输出结果的记录,以保护用户隐私。阅读博客文章 Gemini Nano 隐私与安全简介 了解更多信息。

使用 AICore 访问 AI 基础模型的优势

AICore 使 Android 操作系统能够提供和管理 AI 基础模型。这显著降低了在应用中使用这些大型模型的成本,主要原因如下:

- 易于部署:AICore 管理 Gemini Nano 的分发并处理未来的更新。你无需担心通过网络下载或更新大型模型,也无需担心对应用磁盘和运行时内存预算的影响。

- 推理加速:AICore 利用设备端硬件加速推理。你的应用可在每台设备上获得最佳性能,并且你无需担心底层硬件接口。

支持的功能

- 支持的设备:带有 Google AI Edge SDK 的 Gemini Nano 可在 Pixel 9 系列设备上进行实验。

- 支持的模态:AICore 支持 Gemini Nano 的文本模态。

对更多设备和模态的支持是当前积极投入的领域。

用例

与云服务器相比,移动设备的资源限制导致设备端生成式 AI 模型在设计时注重效率和大小。这种优化优先处理特定、明确定义的任务,而非更通用的应用。合适的用例包括:

- 文本复述:修改文本的语气和风格(例如,从随意到正式)。

- 智能回复:在聊天线程中生成与上下文相关的回复。

- 校对:识别并纠正拼写和语法错误。

- 摘要:将冗长的文档浓缩为简洁的摘要(段落或要点)。

为了获得最佳性能,请参阅 提示策略 文档。要亲身体验这些用例,请下载我们的示例应用并开始使用 Gemini Nano 进行实验。

Gemini Nano 已被多个 Google 应用使用。一些示例如下:

- Talkback:Android 的无障碍应用 Talkback 利用 Gemini Nano 的多模态输入功能来改进视障用户的图片描述。

- Pixel 录音机:Pixel 录音机 应用使用 Gemini Nano 和 AICore 来支持设备端摘要功能。录音机团队采用了最新的 Gemini Nano 模型,以支持更长的录音并提供更高质量的摘要。

- Gboard:Gboard 智能回复利用设备端 Gemini Nano 和 AICore 提供准确的智能回复。